On l’a déjà dit (discrètement) ici : Siffler en travaillant mais je pense qu’il faut arrêter d’être discret quand les développeurs partent dans la Silicon Valley pour l’argent alors qu’on peut rester en France et vivre très bien aussi ! Et quand je dis très bien, je veux dire : vraiment très bien. En doublant nos revenus, on ne double pas simplement notre pouvoir d’achat, mais on le multiplie par 10 !

On l’a déjà dit (discrètement) ici : Siffler en travaillant mais je pense qu’il faut arrêter d’être discret quand les développeurs partent dans la Silicon Valley pour l’argent alors qu’on peut rester en France et vivre très bien aussi ! Et quand je dis très bien, je veux dire : vraiment très bien. En doublant nos revenus, on ne double pas simplement notre pouvoir d’achat, mais on le multiplie par 10 !

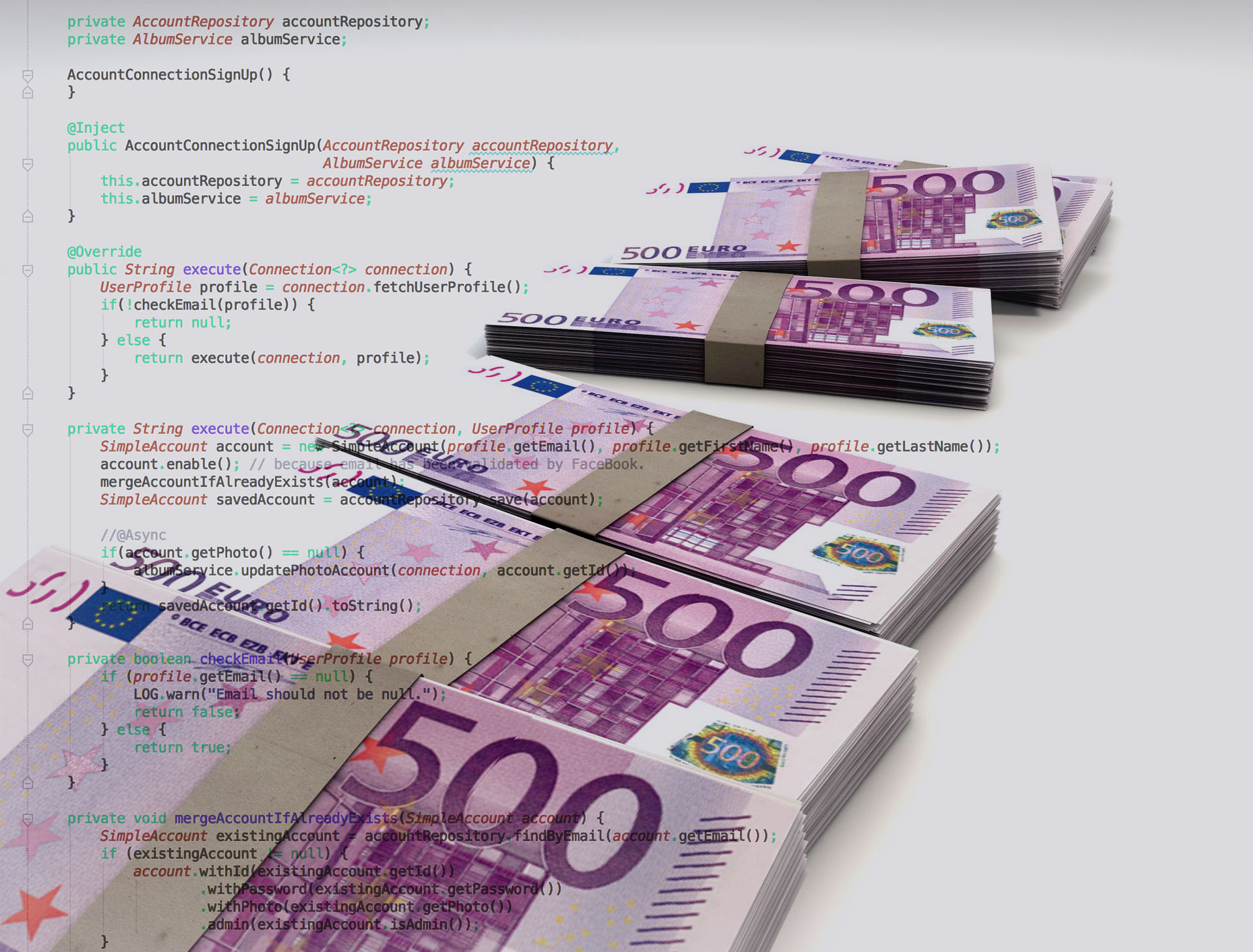

Prenons un exemple simple, tu es développeur Java junior à Paris, Tu gagnes environ 2500€ net par mois. Pas mal ! Mais après avoir payé ton loyer parisien, ton abonnement de transport, tes impôts, tes courses et les billets de trains pour aller voir Maman de temps en temps, il te reste combien ? 200€ 300€ ? Imagine maintenant que tu gagnes 5000€ net par mois. Tu vas payer plus d’impôts certes mais grosso modo, il te restera tout de même environ 2500€ à la fin du mois, soit 10x plus qu’avant. Rien que ça. Et pour l’avoir vécu, c’est juste énorme. Et non, je crois que tu ne te rends pas compte. Tu ne te rends pas compte de ce que c’est de ne pas savoir combien t’ont coûté tes courses, de répondre tout le temps « bof, ça va » quand quelqu’un te dit « Mais c’est super cher ! » ou encore de regarder ton compte en te disant « Mais pourquoi j’ai autant d’argent ? »

Oouhaa ouhaaa…. cool alors c’est quoi la recette miracle ? Elle est très simple : passer freelance. Tu peux calculer tes futurs revenus sur la Calculatrice freelance ou à la suite en fonction de ton expérience :

- Débutant : Ancien salaire net moyen : 2000€. Tarif journalier moyen : 320€ (=4000€ net de revenus en indépendant)

- Junior : Ancien salaire net moyen : 2500€. Tarif journalier moyen : 400€ (=5000€ net de revenus en indépendant)

- Expérimenté : Ancien salaire net moyen : 3000€. Tarif journalier moyen : 500€ (=6000€ net de revenus en indépendant)

Bien évidemment je compare ce qui est comparable, les montants donnés sont bien ceux que tu indiqueras dans la case « Traitements et salaires » de ta déclaration de revenus. Et en plus la réalité est encore plus drôle pour le freelance, mais n’en rajoutons pas avec cet iPhone 6 à 900€ que tu vas payer hors taxes et hors charges via ta société sous prétexte que tu expérimentes le développement mobile.

Vous en doutez ? Et vous avez raison, les freins psychologiques sont nombreux au passage en freelance : Comment trouver un client ? Et si le client refuse de me payer ? Et la comptabilité ? Je me suis posé les mêmes questions ! Et je peux vous rassurer tout de suite, toutes les personnes que je connais qui ont eu la folie d’y aller vous diront pareil que moi : C’est plus simple que ce qu’on s’imagine et plus jamais je ne ferai marche arrière ! Comme toi, nous étions (et sommes restés) simplement développeur sans autre compétence que celle de savoir coder.

Edit 2017 :

Plus aucune raison de ne pas se lancer, trouver une mission est devenu très facile avec des sites comme Hopwork pour capitaliser sur sa réputation ou Tiime pour la comptabilité !

]]>

Si on considère la classe Color qui comporte 2 méthode : une qui change les 2 champs preferedColor et colorOfMyDress avec la même couleur donnée en paramètre et une qui affiche les 2 champs.

public class Color {

public String preferedColor;

public String colorOfMyDress;

public void changeColor(String color) {

preferedColor = color;

colorOfMyDress = color;

}

public void printColor() {

System.out.println("Ma couleur préferée est le " + preferedColor + " et la couleur de ma robe est " + colorOfMyDress);

}

}

Imaginons une classe AuroreColor qui ressemble à celle la et que cette classe soit utilisée dans une appli web, et l’on souhaite que tous les utilisateurs puissent modifier la couleur qui est partagée entre tous :

public class AuroreColor {

public Color color;

...

}

Chaque utilisateur peut changer la couleur via une interface et en réponse, s’affiche le texte affiché par la méthode printColor(). Si Paul choisit et valide la couleur rouge, alors il voit à l’écran : « Ma couleur préferée est le rouge et la couleur de ma robe est rouge. »

Mais si 2 utilisateurs utilisent en même temps cette fonctionnalité, on peut obtenir des résultats « non attendus » comme « Ma couleur préferée est le vert et la couleur de ma robe est jaune », alors qu’on s’attends à ce que les 2 champs soient identiques.

En effet, il est (entre autre) possible que au même moment, les threads associés à chacun des utilisateurs soient au même moment au sein de la méthode changeColor, impliquant que pour un laps de temps très court, les 2 paramètres sont modifiés et ont des valeurs différentes. C’est particulièrement visualisable si on reprends l’exemple d’un counter :

public class Counter {

double counter;

public void increment() {

counter++;

}

public double getCounter() {

return counter;

}

}

On essaie de compter le nombre de mots d’un livre mais on se rends compte que le résultat n’est pas toujours correct. La cause est assez simple : counter++ marche de la façon suivante :

– Je récupère la valeur de counter

– J’ajoute 1

– J’affecte le résultat à counter

Si 2 threads accèdent l’un après l’autre à ce code, pas de problème. Par contre, si 2 threads appelent la méthode incrémente dans un laps de temps très court, alors il est possible qu’ils utilisent la même valeur de counter lors de l’incrémentation, alors, chacun va faire un +1, sur la même valeur et réassignée cette valeur à counter. Ainsi, on aura au final, counter = 1 alors que l’un après l’autre, on voit bien counter = 2.

En séquence on aura :

Thread 1 :

Valeur de counter initial : 0

Valeur après incrémentation : 1

Thread 2 :

Valeur de counter initial : 1

Valeur après incrémentation : 2

Soit un résultat final de 2

En parrallèle, on peut avoir :

Thread 1 :

Valeur de counter initial : 0

Valeur après incrémentation : 1

Thread 2 :

Valeur de counter initial : 0

Valeur après incrémentation : 1

Soit un résultat final de 1

Il y a plusieurs manières de résoudre ce problème. L’un d’elle serait de garantir que 2 threads ne puissent pas accéder en même temps à la méthode changeColor (ou increment) en utilisant le mot clé synchronized sur cette méthode . Si on reprends les explications pour une méthode synchronized :

- First, it is not possible for two invocations of synchronized methods on the same object to interleave. When one thread is executing a synchronized method for an object, all other threads that invoke synchronized methods for the same object block (suspend execution) until the first thread is done with the object.

- Second, when a synchronized method exits, it automatically establishes a happens-before relationship with any subsequent invocation of a synchronized method for the same object. This guarantees that changes to the state of the object are visible to all threads.

Pour faire plus simple, le mot clé synchronized sur une méthode garantit que cette dernière ne sera exécutée qu’un par au plus un thread, les autres attendant que le premier ait finit.

public class Color {

public String preferedColor;

public String colorOfMyDress;

public synchronized void changeColor(String color) {

preferedColor = color;

colorOfMyDress = color;

}

public void printColor() {

System.out.println("Ma couleur préferée est le " + preferedColor + " et la couleur de ma robe est " + colorOfMyDress);

}

}

En modifiant de la sorte, 2 threads ne pourront jamais modifier en même temps les couleurs, mais seulement l’un après l’autre. Mais il y a un mais, car cela ne marche pas et cela fait partie des erreurs que l’on retrouve souvent

]]>

Déjà eu envie de faire de l’open-source mais ne sachant pas comment débuter ? Vous avez un projet open-source et cherchez un coup de main ? Quelque soit votre situation, le Hackergarten qui aura lieu mercredi après midi lors de Devoxx France est LE lieu où il faut être, vous y trouverez des commiteurs qui vous accompagnerons pour faire votre premier commit open-source sur un des projets représentés ! Organisé par Brice Dutheil et Mathilde Lemée, c’est un bon moyen de progresser et de se rendre utile.

Hackergarten c’est le rendez-vous des gens qui veulent participer aux projets opensource. L’idée c’est, dans un format de 3h, de contribuer un logiciel, un fix, un feature, une documentation dont d’autres pourraient avoir l’usage. Il s’articule autour de commiters actifs pour mentorer les hackers qui participent à l’évènement.

Bref que du bon.

Voilà la liste des projets qui seront représentés :

- Achilles

- FluentLenium

- CRaSH

- Ceylon

- Apache Maven

- Jenkins

- Restx

- Voxxrin

- Hibernate OGM

- Hibernate Search

- EasyMock

- Objenesis

- Spek

- et d’autres à venir !

La liste n’est pas fixée, commiters, vous pouvez vous ajouter ici ! Il vous faudra venir avec votre portable et n’hésitez pas à regarder les pré-requis pour pouvoir démarrer plus rapidement !

]]>

Je me rends compte que je n’ai encore pas fait d’article sur le projet que me prend 90% de mon temps ces derniers temps : Hopwork.

Je me rends compte que je n’ai encore pas fait d’article sur le projet que me prend 90% de mon temps ces derniers temps : Hopwork.

Sérieusement, on est en train de révolutionner le monde des intermédiaires sans foi ni loi. En quelques mots :

- Le site est entièrement gratuit tant qu’on n’a pas un devis accepté.

- La commission est 3 fois moins importante qu’un intermédiaire classique (moins de 10% pour Hopwork contre 15%-25% actuellement)

- On peut contractualiser en direct (ou pas, à vous de choisir)

- Les freelances sont « approuvés » par leurs pairs et par leurs clients

Pas de ticket d’entrée

Non mais allô quoi, payer pour chercher un développeur ou une mission alors qu’on n’est pas sûr de trouver un deal ? Ça gave ! Hopwork prend clairement le modèle d’Airbnb, on cherche autant qu’on veut, on ne paye que si on trouve !

Commission raisonnée

Quand un intermédiaire classique prend facilement 20% si ce n’est plus, Hopwork ne prendra que 9% sur des missions courtes et ce sera bientôt dégressif en fonction du volume. Quoi de plus logique ? On paye la mise en relation, c’est ce qui a le plus de valeur, ensuite on paye le service (facturation, paiement, litige, recommandations clients etc.)

Contractualisation en direct

Là aussi, franchement en tant que freelance, je ne veux pas avoir une 3ème personne dans la relation, qui a des intérêts potentiellement divergents des miens. Et pour le client qui souhaite pouvoir parler à quelqu’un d’autre que le freelance pour des raisons qu’on peut imaginer aisément (notamment en cas de litige), le service client d’Hopwork est là pour ça !

Freelances approuvés

En plus de la localisation, le moteur de recherche met en avant les freelances qui ont le plus de recommandations et le plus de commentaires satisfaisants des clients. Un gage de sécurité pour le client et un bon moyen de se mettre en avant et d’augmenter son business pour les meilleurs d’entre nous !

Garantie de paiement

Pour les missions courtes, le client déposera un acompte sur un compte de séquestre. Pour une mission longue, Hopwork se chargera du recouvrement. Zéro tracas, Zéro blabla pour reprendre une pub bien connue

Nouveaux clients

Les clients sont souvent verrouillés par les SSII et autres intermédiaires (qui en profitent bien en passant pour faire de belles marges mais passons). Hopwork déverrouille ces clients en ce faisant référencer pour vous. Et va même plus loin en entrant chez certains clients réputés pour ne pas prendre de freelances ! Et n’oubliez pas, vous contractualisez avec le client, ouf non ?

Elle est où l’arnaque ?

L’astuce est dans le contrat que vous faites avec Hopwork, en vous inscrivant sur Hopwork, vous vous engagez à payer la mise en relation à Hopwork. Hopwork vous enverra une facture pour chaque mise en relation.

Quoi encore une facture à payer ? relou !!

Non pas relou, le client vous paye en passant par la plateforme de paiement Hopwork. (Virement ou CB) Ensuite Hopwork vous envoie votre part défalqué de la commission. Comptablement vous avez fait 100% du CA et payé une prestation de mise en relation. Toutes les factures sont générées et disponibles à tout moment. Vous n’avez rien de fait de plus que d’habitude. : Zéro tracas, Zéro blabla !

Alors, bonne idée ? Allez-vous nous rejoindre sur Hopwork et participer à l’aventure ?

]]>Une des grandes idées des architectures orientées data (Buzz words : OpenData, BigData) est de laisser la possibilité de poser des questions, inconnues aujourd’hui mais qui pourront s’exécuter demain sur les données d’aujourd’hui. Pour cela il suffit “simplement” de stocker les données plutôt qu’un état (calculé à partir des données).

Qu’est ce que la data ?

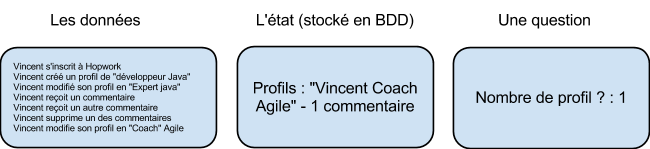

Une idée reçue est que la data est ce qui est stocké en base de données. Voici un exemple simple d’interaction avec un site web :

La data, (ou les données) sont toutes les informations immuables que nous pouvons récolter, dans cette exemple il s’agit des actions exercées sur notre site. Les données, ce sont des faits, des vérités, et non pas des états calculés.

Cas d’utilisation des data

Dans une application classique, seul l’état est stocké en base, et il est possible de poser des questions au système, par exemple : combien il y a t’il de profils sur mon site ? Qui est coach Agile ? etc.

En revanche, certaines questions seront impossibles à poser au système ou retourneront un résultat erroné :

-

Combien de personnes connaissent Java ? (L’info est perdu pour Vincent).

-

Combien de commentaires Vincent à t’il reçu ? ( 2 en réalité)

-

Qui crée des profils factices pour augmenter artificiellement son nombre de commentaires ? (Pour cette question il faudrait stocker des informations techniques et faire des recoupements, conserver une trace des comptes supprimés etc..)

Et, plus amusant des questions utilisant des données externes, telle que la météo par exemple :

-

Quel temps fait il le plus souvent lorsqu’un profil et créé ? Lorsqu’il est supprimé ?

Ce genre de questions peutt être utile pour des scientifiques dans des domaines tels que l’anthropologie !

Ou pas ! En réalité, il est difficile de prévoir comment les données vont être utilisées demain. Peut être pour proposer une fonctionnalité de recommendation poussée, ajouter une nouvelle statistique pour analyser les futures campagnes marketing d’Hopwork par exemple… Qui sait ? Ce que nous savons en revanche, c’est qu’il faut absolument, non pas stocker simplement un état calculé mais bien l’ensemble des données du site afin de pouvoir nous en servir dans le futur.

Mise en oeuvre technique

Pour mettre en oeuvre nos cas d’usages et les cas d’utilisations futurs et encore inconnus, nous allons rencontrer de nombreux problèmes techniques :

-

Stockage des données : Stocker l’ensemble des faits plutôt qu’un état demande beaucoup plus d’espace de stockage et cet espace augmente constamment dans le temps même si la base des utilisateurs reste fixe. Elle augmente donc à la fois dans le temps et en fonction du nombre d’utilisateur et aussi du nombre de fonctionnalités qui s’ajoute au fur et à mesure de la vie d’une application.

-

Performance lors du requêtage : Une base de données de faits n’est pas optimisé pour poser des questions. Par exemple, pour connaître le nombre de commentaires visibles de Vincent nous sommes obligé de relire tous les faits liés à Vincent. Et ce nombre de faits augmente sans cesse, le temps de calculer une réponse sur ces faits sera de plus en plus long et coûteux.

-

Véracité des faits : Les faits ne doivent jamais être corrompus sans quoi il serait impossible de calculer un état stable du système et nos données ne serviraient plus rien. L’avantage des faits est qu’on ne les change jamais, on se prémunit ainsi des erreurs humaines (ie des algorithmes comportant des bugs). Il ne reste donc plus qu’a se protéger des erreurs machines (coupure électrique, pannes etc..)

Pour résoudre le problème du stockage, il faut mettre en place des solutions de système de fichiers distribués. Il en existe sur le marché, Hadoop par exemple. Afin de garantir la véracité des faits, il nous faut un système qui ne tombe jamais en panne, pour cela nous pouvons nous orienter vers des systèmes redondants telle que mis en oeuvre dans le cloud.

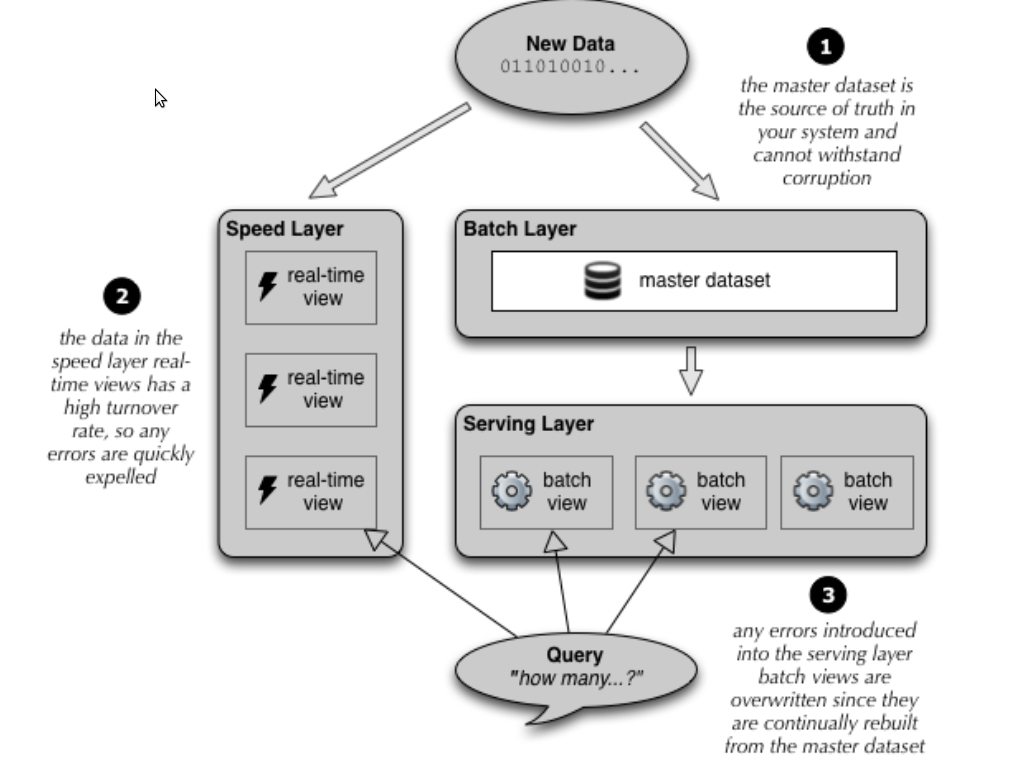

Pour résoudre les problèmes de performance nous pouvons mettre en oeuvre une “lambda architecture”.

Lambda Architecture

Lorsqu’une donnée entre dans le système (une action sur le site par exemple), elle est :

- traitée par les speeds layers afin de recalculer au fil de l’eau les vues « optimisées pour la lecture ». Idéalement on cherchera à atteindre une complexité constante en lecture pour chaque vue quitte à faire un calcul inexacte lorsque cela est acceptable. Comme la vue est déjà précalculé depuis l’état N-1, il est le plus souvent possible de la mettre à jour avec une complexité constante également. On s’est amusé ici avec des bases orienté lecture (SQL, Mongo, Redis etc..) ainsi que des architectures à base de composants et de queues (JMS, Akka etc.)

- stockée en parallèle dans notre base de faits (Batch layer). En mode ‘append only’. Là encore il faut viser une complexité d’écriture constante. On pourra s’amuser à utiliser Cassandra qui à l’avantage de nous permettre de stocker les faits ordonnés, ce qui peut se réveler très utiles pour recalculer nos vues à partir d’un instant T ou tout simplement pour le parcours des données. On pourra également stocker les données dans Hadoop, tout dépendra de la nature de celles-ci et de ce qu’on veut en faire.

Le serving layer permet de calculer les vues à partir de la base de faits. Il a toujours un temps de retard mais garantie des snapshots du système précis. Il suffit pour les speeds layers de rejouer les données entre un snapshot et le présent pour se « mettre à jour ».

Ainsi en cas de bug détecté à la fois sur le speed layer et le batch layer, il suffit livrer le code corriger du speed layer, recalculer depuis la snapshot qui correspond à la mise en prod du bug jusqu’à aujourd’hui avec les servings layers, puis serving ce snapshot au speeds layers qui recalculeront depuis ce snapshot jusqu’au nouveau présent. Il est donc inutile de couper le site pendant 5 jours, le temps de reprendre les données (je dit ça car c’est du vécu).

En résumé

En tant que professionnel, il du plus mauvais effet de devoir dire à un client qu’on a perdu des informations, à cause d’un système basé sur des updates. Une application basique se contente souvent de n’avoir que des speed layers et des vues. Lassé de paraître ridicule quand on nous demande ce qu’il se passe sur notre système, on y ajoute un système de log déstructuré qui est souvent insuffisant.

Aussi, les bugs corrompent les données et il est parfois impossible de les restaurer.

Finalement, mettre une place une architecture orienté data est plus couteuse qu’une application basique mais elle rend obsolète le besoin de logguer et permet de faire infiniement plus de choses, comme la restauration du système lorsqu’un bug a corrompu les vues, et la possibilité d’ajouter des fonctionnalités d’historique qui fonctionneront sur les données du passé.

Pour creuser le sujet, je vous conseille de lire l’excellent livre : Big Data

]]>

Je commence par le CV, j’ai souvent des gens qui ont plus de 15ans d’expériences donc je demande les 2 expériences les plus importantes pour eux et de les détailler (technos, nombre de personne dans l’équipe, challenges techniques/humains).

J’embraye sur des questions basiques sur les tests en fonction du cv du candidat :

- Différence entre JUnit et testNG et pourquoi on préfère l’un à l’autre

- Qu’est ce qu’un mock

- Qu’est ce qu’une Rules JUnit

- Quel est le moyen le plus simple de relancer n fois un test avec testNG ? Et sur plusieurs threads ?

- Quels frameworks de tests connaissez vous ? (culture G)

- Qu’est ce qu’un test paramétré (+ explications de la syntaxe) ?

Quelques basiques questions sur maven :

- Quels sont les différentes scopes ?

- Citer un plugin maven dédié au test ?

- Quelle est la différence entre maven et ant ?

- Comment activer un profile ?

Ensuite je passe sur la concurrence :

- Qu’est ce qu’une race condition ?

- Qu’est ce que volatile ?

- Est ce que ca garantit l’atomicité ?

- Qu’est ce que l’atomicité ?

- Comment marche l’intérieur de la ConcurrentHashMap ?

- Qu’est ce qu’une barrière ?

Culture G :

- Quel est le dernier livre technique que vous ayez lu ?

- Quel est votre livre technique préféré ?

J’aime bien aussi quand le candidat a un compte github.

Vu le poste, on veut des gens qui connaissent un minimum la concurrence (Java concurrency in practice est un très bon livre sur le sujet), un minimum de maven et un bon niveau de test.

Je continue jusqu’à ce que le candidat ne sache plus répondre pour chacun des 3 blocs. J’ai enlevé toutes les questions type SCJP, ca s’apparente trop à du bachotage. J’essaie de garder à peu près les memes questions pour pouvoir différencier les candidats.

Ensuite, on vient d’ajouter le kata sur les chiffres romains qu’on demande de mettre sur github pour voir si la personne sait effectivement coder. La dessus, je n’ai pas encore de retour mais j’espère bien que ca permettra de bien voir si la personne sait mettre en place un minimum de bonnes pratiques.

Et je recherche de nouvelles idées !

Et comment est ce que je sélectionne ?

Il est normal de ne pas tout savoir ! Avant toute chose, on essaie de voir surtout si le candidat réfléchit bien. C’est aussi utile pour moi de voir comment le candidat réagit quand il ne connait pas. Est-ce qu’il pipeaute, qu’il admet, qu’il tente un truc ? C’est surtout vrai pour les questions sur la concurrence et notamment la question sur la concurrent hashmap.

Les seuls points bloquants seraient une lacune complète sur les tests et sur maven. Sur la concurrence, je conseille en entretien de lire Concurrency in Practice. Et pour les lecteurs de ce blog,si vous n’avez qu’un temps réduit, il y a une refcard écrite par un ancien de terracotta sur DZone qui date un peu http://refcardz.dzone.com/refcardz/core-java-concurrency mais qui est claire. Pour postuler pour un job sur un cache distribué, maitriser un peu les concepts de concurrence c’est apprécié.

Merci à tous ceux qui m’ont aidé hier sur twitter !

]]> Pour commencer 2013 en beauté, rien de mieux que de finir l’année avec une mission pleine de nouveaux challenges et de nouvelles technos : Cassandra, Play!, EJB3 (!) et Arquillian.

Pour commencer 2013 en beauté, rien de mieux que de finir l’année avec une mission pleine de nouveaux challenges et de nouvelles technos : Cassandra, Play!, EJB3 (!) et Arquillian.

Arquillian est un outil qui permet de faire des tests d’intégration. Il permet notamment de construire programmatiquement des jar, war et ear très simplement et de déployer ces pseudos-livrables dans un serveur embarqué.

Étant adepte du TDD, quand on me demande de faire un service web, j’aime me mettre à la place du client web et manger du HTTP afin de vérifier le contenu des retours mais aussi les entêtes, les E-Tag, la compression etc… C’est que nous permet de faire Rest-Assured. Nous allons justement voir dans cet article comment tester un service web par la couche HTTP en se servant d’Arquillian pour déployer le service de manière embarqué.

Dans cet exemple, nous utilisons le serveur glassfish embedded. Nous testons un service REST permettant de consulter des logs applicatifs. Ainsi on souhaite vérifier que la requête HTTP : « GET http://localhost:8181/logs?severity=error » retourne bien un code HTTP 200 OK.

Le Test

Voici le code test que nous souhaitons faire :

import org.jboss.arquillian.container.test.api.RunAsClient;

import org.jboss.arquillian.junit.Arquillian;

import com.jayway.restassured.RestAssured;

import com.jayway.restassured.parsing.Parser;

import com.jayway.restassured.specification.ResponseSpecification;

import static com.jayway.restassured.RestAssured.expect;

import static com.jayway.restassured.RestAssured.given;

@RunWith(Arquillian.class)

public class SomeArquillianTest{

@Test

@RunAsClient

public void simpleClientTestExample(@ArquillianResource URL baseURL) throws IOException {

expect().statusCode(200).when().get(baseURL.toString() + "logs?severity=ERROR");

}

}

- @RunWith(Arquillian.class) permet d’utiliser le runner JUnit d’Arquillian.

- @RunAsClient permet de marquer le test comme étant un test de type « Client ».

- @ArquillianResource permet d’injecter l’url de base afin de connaitre l’addresse http de l’application.

Créer l’archive à déployer

Afin qu’Arquillian puisse créer une archive de déployement, il suffit de lui spécifier les composants que nous souhaitons tester (classe annotées @Stateless par exemple.) ainsi que le container / Servlet et le fichier web.xml .

import com.sun.jersey.spi.container.servlet.ServletContainer;

import org.jboss.arquillian.container.test.api.Deployment;

import org.jboss.arquillian.test.api.ArquillianResource;

import org.jboss.shrinkwrap.api.Archive;

import org.jboss.shrinkwrap.api.ArchivePaths;

import org.jboss.shrinkwrap.api.ShrinkWrap;

import org.jboss.shrinkwrap.api.asset.EmptyAsset;

import org.jboss.shrinkwrap.api.spec.WebArchive;

@RunWith(Arquillian.class)

public class simpleClientTestExample {

@Deployment

public static Archive<?> createTestArchive() {

return ShrinkWrap.create(WebArchive.class)

.addPackages(true, Log.class.getPackage(),

LogServiceRest.class.getPackage(),

LogService.class.getPackage())

.addClass(ServletContainer.class)

.setWebXML("WEB-INF/web.xml")

}

Changer le port du serveur embarqué

- Le port par défault pour glassfish-embedded est : 8181 (https://docs.jboss.org/author/display/ARQ/GlassFish+3.1+-+Embedded)

- Il est possible de surcharger cette propriété, comme toutes les autres d’ailleurs, dans le fichier arquillian.xml :

<arquillian xmlns="http://jboss.org/schema/arquillian"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://jboss.org/schema/arquillian http://jboss.org/schema/arquillian/arquillian_1_0.xsd">

<engine>

<property name="deploymentExportPath">target/arquillian</property>

</engine>

<container default="true" qualifier="glassfish">

<configuration><property name="bindHttpPort">8181</property></configuration>

</container>

</arquillian>

La pomme

Voici un extrait de ma pomme, à adapter selon votre situation…

<dependencies>

<dependency>

<groupId>org.glassfish.main.extras</groupId>

<artifactId>glassfish-embedded-all</artifactId>

<scope>provided</scope>

</dependency>

<dependency>

<groupId>javax</groupId>

<artifactId>javaee-api</artifactId>

<scope>provided</scope>

</dependency>

<!-- Librairies for test -->

<dependency>

<groupId>org.hamcrest</groupId>

<artifactId>hamcrest-library</artifactId>

<version>1.3</version>

<scope>test</scope>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

</dependency>

<dependency>

<groupId>org.jboss.arquillian.junit</groupId>

<artifactId>arquillian-junit-container</artifactId>

<scope>test</scope>

</dependency>

<dependency>

<groupId>com.jayway.restassured</groupId>

<artifactId>rest-assured</artifactId>

<scope>test</scope>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-war-plugin</artifactId>

<version>2.2</version>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-dependency-plugin</artifactId>

<version>2.1</version>

<executions>

<execution>

<phase>validate</phase>

<goals>

<goal>copy</goal>

</goals>

<configuration>

<outputDirectory>${endorsed.dir}</outputDirectory>

<silent>true</silent>

<artifactItems>

<artifactItem>

<groupId>javax</groupId>

<artifactId>javaee-endorsed-api</artifactId>

<version>6.0</version>

<type>jar</type>

</artifactItem>

</artifactItems>

</configuration>

</execution>

</executions>

</plugin>

</plugins>

</build>

Et voilà ! Plutôt simple non ?

]]>- les annotations de mapping

- les apis

- la sémantique (cascade …)

- et le JP-QL

Plus d’infos sur le blog d’Emmanuel Bernard

Alors qu’au début, il n’y avait que Infinispan, on peut désormais y trouver MongoDB et Ehcache. D’autres types viendront surement. Ici, Ehcache est utilisé non pas comme un cache mais comme un datastore noSQL clé/valeur.

Configuration

Pour effectuer des insertions dans Ehcache via OGM, c’est vraiment simple. Après avoir ajouter la dépendance hibernate-ogm-ehcache à votre POM, il faut ensuite faut un fichier persistence.xml.

<persistence xmlns="http://java.sun.com/xml/ns/persistence"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://java.sun.com/xml/ns/persistence http://java.sun.com/xml/ns/persistence/persistence_2_0.xsd"

version="2.0">

<persistence-unit name="ogm-ehcache" transaction-type="JTA">

<provider>org.hibernate.ogm.jpa.HibernateOgmPersistence</provider>

<properties>

<property name="hibernate.ogm.datastore.provider"

value="ehcache"/>

<property name="hibernate.transaction.jta.platform"

value="org.hibernate.service.jta.platform.internal.JBossStandAloneJtaPlatform"/>

</properties>

</persistence-unit>

</persistence>

Note : Actuellement, les transactions, qui sont gérées de manière native par Ehcache, ne fonctionnent pas avec OGM.

Il faut ensuite instancier l’entityManager.

Configuration cfg = new OgmConfiguration().

setProperty("hibernate.ogm.datastore.provider", "ehcache").

addAnnotatedClass(Appli.class).addAnnotatedClass(Platform.class);

TransactionManager tm = getTransactionManager();

EntityManagerFactory emf = Persistence.createEntityManagerFactory("ogm-ehcache");

try {

EntityManager em = emf.createEntityManager();

Many-to-One

Le modèle est le suivant : 2 classes, Appli et Perform.

@Entity @Indexed

public class Appli {

@Id

@GeneratedValue(strategy = GenerationType.TABLE, generator = "appli")

@TableGenerator(

name = "appli",

table = "sequences",

pkColumnName = "key",

pkColumnValue = "apply",

valueColumnName = "seed"

)

public Long getId() { return id; }

public void setId(Long id) { this.id = id; }

private Long id;

public String getName() { return name; }

public void setName(String name) { this.name = name; }

private String name;

@ManyToOne

@IndexedEmbedded

public Platform getPlatform() { return platform; }

public void setPlatform(Platform platform) { this.platform = platform; }

private Platform platform;

}

@Entity @Indexed

public class Platform {

@Id

@GeneratedValue(generator = "uuid")

@GenericGenerator(name="uuid", strategy="uuid2")

public String getId() { return id; }

public void setId(String id) { this.id = id; }

private String id;

@Field

public String getName() { return name; }

public void setName(String name) { this.name = name; }

private String name;

}

On crée ensuite un objet learnAnimals de type Appli qui a pour plateforme itunes.

Platform itunes = new Platform();

itunes.setName("iTunes");

Appli learnAnimals = = new Appli();

learnAnimals.setName("J apprends les animaux" + i);

learnAnimals.setPlatform(itunes);

On persiste de la meme manière qu’avec hibernate.

tm.begin(); em.persist(learnAnimals); Long leanAnimalsId = learnAnimals.getId(); em.flush(); em.close(); tm.commit();

Et voilà, l’objet learnAnimals est persisté. Mais à la différence d’une persistance classique avec Ehcache, qui fonctionne par sérialisation/déserialisation des objets, le modèle est déshydraté.

tl;dr

Pour une entité, elle est donc stockée dans une store ENTITIES avec le modèle clé/valeurs suivant :

Clé

Chaque clé est de type EntityKey, classe qui contient entre autre :

private final String table; private String[] columnNames; private Object[] columnValues;

On aura par exemple : {table=’Appli’,columnNames=[‘id’],columValues=[‘1’]} pour l’appli qui a pour identifiant la valeur 1.

Pour la valeur, elle est construite sous la forme d’une map.

Ainsi pour un object Appli qui contient une Plateforme, la map aura cette forme :

Clé | Valeur id | 1 name | monAppli platform_id | 65d2183a-3a73-4079-83fb-57f9072e0915

A l’insertion c’est un peu plus compliqué. On passera par des objets transitoires, des aggregats nommé TupleOperation qui contiennent le nom de la colonne, sa valeur et son type TupleOperationType, celui-ci pouvant prendre 3 valeurs, PUT, PUT_NULL et REMOVE.

On a donc en fait :

Key | Value

id | {columnName='id',columnValue='1'.columnType=TupleOperationType.PUT}

name | {columnName='name',columnValue='monAppli'.columnType=TupleOperationType.PUT}

platform_id | {columnName='platform_id',columnValue='2886a75c-11ae-4f3d-a132-8d58010382b3'.columnType=TupleOperationType.PUT}

La valeur PUT indiquera qu’il faut faire un

map.put( action.getColumn(), action.getValue() );

C’est à dire pour le premier exemple :

map.put('id',1)

Un remove aurait entrainé une suppression de la paire clé/valeur. Un PUT_NULL fait la même chose qu’un PUT.

On a donc bien inséré en base :

Clé | Valeur id | 1 name | monAppli platform_id | 65d2183a-3a73-4079-83fb-57f9072e0915

On aura une entrée similaire dans le meme cache ENTITIES pour les objets de types Platform. Pour résumer, on a donc :

Map<EntityKey,Map<String,Object>>

La deuxième store est la store ASSOCIATION. Elle n’est utile que dans les relations plus complexes.On y reviendra par la suite. Dans ce cas, elle reste vide.

La troisième store est la store des IDENTIFIERS, qui stocke les informations relatives aux séquences, notamment toutes celles qui permettent de gérer de manière automatique les identifiants.

Many-to-Many

On définit maintenant une application comme pouvant être associée à N plateforme. Le modèle de Platform ne change pas, celui d’Appli légerement.

@Entity @Indexed

public class AppliManyToMany {

@Id

@GeneratedValue(strategy = GenerationType.TABLE, generator = "appli")

@TableGenerator(

name = "appli",

table = "sequences",

pkColumnName = "key",

pkColumnValue = "apply",

valueColumnName = "seed"

)

public Long getId() { return id; }

public void setId(Long id) { this.id = id; }

private Long id;

public String getName() { return name; }

public void setName(String name) { this.name = name; }

private String name;

@ManyToMany

@IndexedEmbedded

public List getPlatforms() { return platforms; }

public void setPlatforms(List platforms) { this.platforms = platforms; }

private List platforms=null;

}

En ce qui concerne la table ENTITY, elle est un peu modifié.

La clé reste identique, par contre l’enregistrement ayant pour clé platform_id n’existe plus. On a uniquement :

Clé | Valeur id | 1 name | monAppli

L’association est désormais portée par un enregistrement dans la table ASSOCIATION.

La clé, de type AssociationKey, similaire à une EntityKey, représentant l’id 5 :

{table=’AppliManyToMany_Platform’, columnNames=[AppliManyToMany_id], columnValues=[5]}

La valeur est toujours une Map :

Clé (de type RowKey) : {table=’AppliManyToMany_Platform’, columnNames=[AppliManyToMany_id, platforms_id], columnValues=[5, 6301e8be-307f-4884-b3a1-5ec0dad7c3e5]}

Valeur (sous la forme d’une Map): {AppliManyToMany_id=5, platforms_id=2886a75c-11ae-4f3d-a132-8d58010382b3}}

On a donc une structure de la forme :

Map<AssociationKey,Map<RowKey,Map<String,Object>>>

Pour cet exemple, il n’y a qu’une seule plateforme, celle qui a l’id 6301e8be-307f-4884-b3a1-5ec0dad7c3e5, ainsi, on a donc un unique enregistrement dans la map.

Si on prends un exemple où une application est associée à deux personnes (appli avec id= 6):

On pourrait avoir comme clé principale :

table=’AppliManyToMany_Platform’, columnNames=’AppliManyToMany_id’, columnValues=’6′

Puis comme value les couples clés/valeurs suivants :

RowKey 1 :

Clé (RowKey) : {table=’AppliManyToMany_Platform’, columnNames=[AppliManyToMany_id, platforms_id], columnValues=[6, b705d241-b6dd-4a81-9fb2-2f9f732530d7]}

Valeur associée (sous forme de map): {AppliManyToMany_id=6, platforms_id=b705d241-b6dd-4a81-9fb2-2f9f732530d7}

RowKey 2 :

Clé (RowKey) : {table=’AppliManyToMany_Platform’, columnNames=[AppliManyToMany_id, platforms_id], columnValues=[6, 2886a75c-11ae-4f3d-a132-8d58010382b3]}

Valeur associée (sous forme de map): {AppliManyToMany_id=6, platforms_id=2886a75c-11ae-4f3d-a132-8d58010382b3}

On a donc bien pour l’application 6 deux plateformes, la plateforme b705d241-b6dd-4a81-9fb2-2f9f732530d7 et la 2886a75c-11ae-4f3d-a132-8d58010382b3 . Le framework se servira des identifiants dans un deuxième temps pour retrouver dans la table ENTITIES les plateformes correspondantes et les ‘ajoutera’ dans la liste des plateformes de l’application id=6. Pour avoir une idée encore plus concrète, il y a des schémas dans la documentation d’OGM.

A venir : Hibernate Search, Lucene et autres recherches avec Hibernate OGM.

]]> Et oui, bizarre de parler de ça dans un blog qui fait l’apologie du freelancing, mais ceux qui me suivent savent sans doute déjà que je ne suis plus tout à fait seul…

Et oui, bizarre de parler de ça dans un blog qui fait l’apologie du freelancing, mais ceux qui me suivent savent sans doute déjà que je ne suis plus tout à fait seul…

Je suis associé depuis le début de cette année à 4 compagnons d’aventure :

- Hugo Lassiège ( hakanai.free.fr )

- Olivier Girardot ( http://www.readtfb.net/ )

- Florent Biville ( http://florent.biville.net/ )

- Jonathan Winandy ( http://hbrain.net/)

Liberté ++

Et oui, quand on est freelance, on est un peu plus libre qu’un salarié, mais que faire de cette liberté seul ? C’est incroyable ce qu’on peut faire quand on est plusieurs, ne serait que 5 pauvres petits développeurs. Depuis la création de Lateral-Thoughts, il y a quelques mois seulement :

- Nous sommes devenus organisme de Formation (certains freelances le sont aussi mais beaucoup se contentent de se faire porter pour donner des formations)

- Nous avons noué un partenariat avec un éditeur de base de données NoSQL (quel freelance peut faire ça ?)

- Nous nous sommes passé d’intermédiaires ! Certains freelances y arrivent aussi, mais là, c’est juste plus simple.au

Finalement se regrouper dans une structure de type NoSSII(a) telle que LT c’est donner un sens à sa liberté, ou plus généralement, découvrir ce que devrait être une société composée de professionnels de l’informatique.

Tout n’est pas rose

Et oui, ce serait trop facile sinon. LT est une société qui innove dans son organisation en copiant honteusement le principe agile d’auto-organisation. LT est clairement auto-organisée. Chaque membre est libre de prendre le lead sur un sujet qui l’intéresse. Il est parfois rejoint par d’autres, et à chaque fois soutenu par tout le groupe. Mais que faire lorsque personne ne souhaite prendre le lead sur un sujet pourtant important ? Ou que faire si le sujet est trop vaste pour qu’une seule personne s’en occupe alors qu’il faudrait être plusieurs ? L’exemple le plus flagrant est notre site Internet, quelques peu délaissé, faute de temps et de motivation.

Mais ce n’est pas grave, en agrandissant notre cercle, nous trouverons sans nul doute les bras qui nous manquent pour faire aussi bien que nos SSII favorites et bien aimées (Xebia, So@t, Zenika, Valtech, pour ne citer qu’elles). Traduction : nous sommes ouverts aux candidatures.

La cerise sur le gâteau

C’est cool, quand j’étais freelance il m’est arrivé de financer un hands-on ou 2 organisés par Mathilde et les Duchess (Location de la salle ou repas). Mais aurai-je pu me permettre de payer une semaine de startup-week-retreat à 7 développeurs passionnés ? Et non, trop cher pour mon petit porte-monnaie. En revanche, à 5 on peut aisément le faire, et c’est ce que nous avons fait !

Dès demain, nous partons à Guérande, pour 8 jours de code intensif avec 4 membres de LT et 3 potes : @nivdul @piwai et @ubourdon . Au programme, du fun : Scala, Android, MongoDB (rien n’est fixé à l’avance, on décidera sur place ce qu’on fait, à la manière d’un hackergarten). Mais aussi de la souffrance : tennis, piscine, jogging et bodyboard … L’idée c’est vraiment de progresser tous ensemble dans la joie et la bonne humeur ^^

On devrait renouveler l’expérience cet hiver ! Si l’expérience vous intéresse, suivez nos blogs ou nos twitter, ça devrait blogguer pendant la semaine

Trève de blabla, passons au code.

Premièrement, ajouter un champ input acceptant l’ajout de plusieurs fichiers :

<input id="files" multiple="multiple" name="file[]" type="file">

Ensuite, uploadons les fichiers en utilisant les « FormData » d’HTML5 :

var upload = function (file) {

var data = new FormData();

data.append('name', file.name);

data.append('file', file);

$.ajax({

url:'/photo',

data:data,

cache:false,

contentType:false,

processData:false,

type:'POST'

}).error(function () {

alert("unable to upload " + file.name);

})

.done(function (data, status) {

doSomethingUseful(data);

});

};

function multiUpload(files) {

for (var i = 0; i < files.length; i++) {

// Only upload images

if (/image/.test(files[i].type)) {

upload(files[i]);

}

}

}

$(document).ready(function () {

$("#files").change(function (e) {

multiUpload(e.target.files);

})

});

Coté serveur, avec Jersey, il faut inclure le module « multipart » :

<dependency>

<groupId>com.sun.jersey.contribs</groupId>

<artifactId>jersey-multipart</artifactId>

<version>1.13</version>

</dependency>

Ensuite le code est plutôt simple :

import javax.inject.Inject;

import javax.ws.rs.*;

import javax.ws.rs.core.MediaType;

import com.sun.jersey.core.header.FormDataContentDisposition;

import com.sun.jersey.multipart.FormDataParam;

import java.io.IOException;

import org.apache.log4j.Logger;

import org.springframework.stereotype.Controller;

@Controller

@Path("/photo")

public class PhotoResource extends AbstractResource {

private static final Logger LOG = Logger.getLogger(PhotoResource.class);

@Inject

private FileRepository fileRepository;

@GET

@Produces("image/png")

@Path("/{photoId}")

public byte[] photo(@PathParam("photoId") String photoId) {

try {

return fileRepository.get(photoId);

} catch (IOException e) {

LOG.warn("When get photo id : " + photoId, e);

throw ResourceException.notFound();

}

}

@POST

@Consumes(MediaType.MULTIPART_FORM_DATA)

@Produces(MediaType.TEXT_PLAIN)

public String addPhoto(@FormDataParam("file") byte[] photo,

@FormDataParam("file") FormDataContentDisposition fileDetail) {

String photoId = null;

try {

photoId = fileRepository.save(photo);

} catch (IOException e) {

LOG.error("unable to add photo", e);

throw ResourceException.error(e);

}

return photoId;

}

}

Et pour s’amuser, stockons les fichiers dans Mongodb grace à GridFS :

import javax.annotation.PostConstruct;

import javax.inject.Inject;

import com.mongodb.gridfs.GridFS;

import com.mongodb.gridfs.GridFSInputFile;

import java.io.IOException;

import org.apache.commons.io.IOUtils;

import org.bson.types.ObjectId;

import org.jongo.Jongo;

import org.springframework.stereotype.Repository;

@Repository

public class FileRepository {

private Jongo jongo;

private GridFS files;

@Inject

public FileRepository(Jongo jongo) {

this.jongo = jongo;

}

@PostConstruct

public void afterPropertiesSet() throws Exception {

files = new GridFS(jongo.getDatabase());

}

/**

* Save a file and return the corresponding id

*/

public String save(byte[] file) {

GridFSInputFile savedFile = this.files.createFile(file);

savedFile.save();

return savedFile.getId().toString();

}

/**

Return the file

*/

public byte[] get(String fileId) throws IOException {

return IOUtils.toByteArray(files.findOne(new ObjectId(fileId)).getInputStream());

}

}

}

Et si vous voulez faire du drag and drop, il suffit d’inclure ce plugin jQuery : drop.js et de faire comme ceci :

$(document).ready(function () {

$('body').dropArea();

$('body').bind('drop', function (e) {

e.preventDefault();

e = e.originalEvent;

multiUpload(e.dataTransfer.files);

});

});

Sources :

]]>Java Barcamp 8

Le Java Barcamp 8 aura lieu le jeudi 5 juillet. Nous pourrons partager ensemble au cours de discussions libres nos idées et nos dernières nouvelles autour de la plate-forme Java, ce sera un format pique nique alors chacun vient avec une bouteille, de quoi grignoter et vos « accessoires », verres, couverts, tire-bouchons, etc…). Plus d’infos : http://barcamp.org/w/page/54826845/JavaCampParis8

Jam de Code

La semaine suivante, le Jam de Code de la SSII Arolla aura lieu le 12 juillet ! Le principe est simple: venez coder avec d’autres passionnés dans une ambiance détendue ! Plus d’infos : http://www.arolla.fr/evenements-2/jams-de-code/

Hackergarten

Le vendredi 20 juillet, de 19h à 23h, aura lieu un hackergarten dans les locaux de Zenika. C’est le rendez-vous des gens qui veulent participer aux projets open source. L’idée c’est, dans un format de 3h, de contribuer un logiciel, un fix, un feature, une documentation dont d’autres pourraient avoir l’usage. Il s’articule autour de commiters actifs pour mentorer les hackers qui participent à l’évènement. Plus d’infos : http://www.eventbrite.com/event/2737661419

Cassandra Paris Meetup

Le premier Cassandra Paris meetup aura lieu le mercredi 25 juillet de 19h à 22h30 ! Il s’adresse à tous, novices et confirmés ! Il y aura 2 présentations, une intro à Cassandra et une étude d’un cas réel à paper.li . Plus d’infos : http://cassandra-paris.eventbrite.fr/

Si vous connaissez d’autres événements, faites nous en part, nous les rajouterons !

Qu’est ce qu’un Bar Camp ?

Wikipédia :

Wikipédia :

Un BarCamp est une rencontre d’un week-end, une non-conférence ouverte qui prend la forme d’ateliers-événements participatifs où le contenu est fourni par les participants qui doivent tous, à un titre ou à un autre, apporter quelque chose au Barcamp.

C’est le principe pas de spectateur, tous participants. L’événement met l’accent sur les toutes dernières innovations en matière d’applications Internet, de logiciels libres et de réseaux sociaux.

Si vous souhaitez venir, il suffit de s’inscrire ici : http://barcamp.org/w/page/54826845/JavaCampParis

Il y a également un plan précis pour s’y retrouver !

Enfin presque, l’idée est d’installer un server X virtuel : Xvfb

% sudo apt-get install xvfb

Ensuite lancer le server X virtuel :

% Xvfb :1 &

:1 permet de spécifier le nom du « display »

Et pour finir, le build selenium ( ou n’importe quelle commande ayant besoin d’un « display »)

DISPLAY=:1 mvn clean install]]>

Redis est la base de données NoSql que je préfère. Le concept est ultra-simple et j’aime la simplicité. Il faut voir Redis comme une grosse Map<K,V>. Avec la possibilité de faire des requêtes sur les clés.

Redis est la base de données NoSql que je préfère. Le concept est ultra-simple et j’aime la simplicité. Il faut voir Redis comme une grosse Map<K,V>. Avec la possibilité de faire des requêtes sur les clés.

Du coup la documentation de Redis est simple. Un autre truc que j’aime c’est qu’elle spécifie la complexité de chaque opération, ce qui permet au développeur de vérifier à chaque fois que la commande qu’il s’apprête à utiliser n’est pas trop gourmande. De plus, il n’a pas le risque d’oublier de mettre un index sur un champ (combien de fois cela arrive en SQL ou avec MongoDb ! ) car toutes les clés sont par définition « indexées » dans une (Hash) Map.

Simple et (donc ?) performant. Redis est sans doute ce qu’il y a de plus performant en terme de base de données. Nous avons donc intérêt à nous y intéresser avant de chercher des solutions plus complètes et donc plus complexes et moins performantes.

Sauf que, Redis ne stocke que des chaînes de caractères. Comment faire pour stocker nos objets métiers complexes ?

On pourrait simplement utiliser une base de données SQL pour stocker notre modèle et utiliser un ORM pour que ce soit « simple ». Ensuite dans Redis on ne stockerai que la dé-normalisation de certaines requêtes : 3 meilleurs clients => { 1 => id:130 ; 2 => id:345 ; 3 => id:456 } Ainsi la requête pour récupérer les identifiants des trois meilleurs clients se fera en temps constant O(1) puis la requête pour récupérer les données des trois clients dans la base SQL se fera également en temps constant, car les clés primaires sont indexées dans les bases SQL.

Mais il faut avouer que c’est embêtant de devoir gérer deux bases de données, surtout quand on pourrait simplement sérialiser les objets directement dans Redis.

Stocker les objets Java dans Redis grâce à Jackson

Dans notre exemple, le besoin est de pouvoir insérer des liens dans des listes et de pouvoir récupérer en temps constant tous les liens d’une liste donnée.

Jackson est un sérialiseur Objet -> JSON. Ce qui est parfait pour pouvoir lire facilement les objets sérialisé où pour pouvoir les utiliser directement en JavaScript, sans passer par une dé-sérialisation.

On va utiliser JAX-B pour annoter nos objets Java, par exemple :

@XmlRootElement(name = "links")

@XmlAccessorType(FIELD)

public class BannerLink {

private String label;

private String url;

public BannerLink(String label, String url) {

this.label = label;

this.url = url;

}

public String getLabel() {

return label;

}

public String getUrl() {

return url;

}

protected BannerLink(){}

}

Notez que Jackson sait aussi sérialiser des POJOs (sans JAX-B mais avec Setter)

Ensuite il suffit de sérialiser l’objet avec Jackson pour l’insérer dans une liste Redis.

AnnotationIntrospector introspector = new JaxbAnnotationIntrospector();

mapper.getDeserializationConfig().setAnnotationIntrospector(introspector);

mapper.getSerializationConfig().setAnnotationIntrospector(introspector);

jedis.rpush("listKey", mapper.writeValueAsString(link));

Pour la lecture, il suffit de dé-sérialiser les objets de la liste.

mapStringsToLinks(jedis.lrange(key, 0, jedis.llen(key)));

private List mapStringsToLinks(List jedisResult) {

return Lists.transform(jedisResult, toBannerLink());

}

private Function<String, BannerLink> toBannerLink() {

return new Function<String, BannerLink>() {

@Override

public BannerLink apply(@Nullable String link) {

return mapper.readValue(link, BannerLink.class);

}

};

}

Je ne sais pas vous, mais moi je trouve ça vraiment plus simple de persister directement et simplement les instances d’objets, telle quelle, sans se prendre la tête avec du mapping, jointure ou autre joyeuseté.

Performances

Je n’ai pas fait le test avec une base SQL et un ORM de type Hibernate mais n’hésitez pas à forker le code et à le faire, ça m’intéresse.

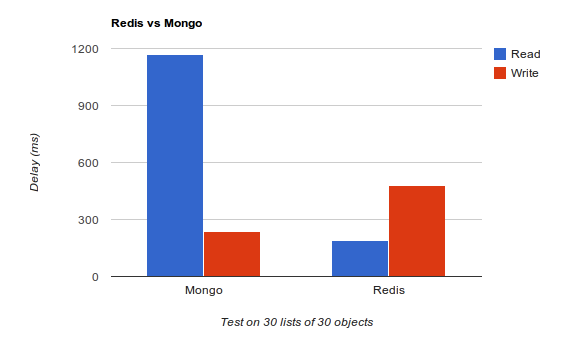

Aucun tuning n’a été fait sur les bases de données. Mongo est bien meilleur en écriture et peut être encore meilleur, car il ne garantie pas que les données sont effectivement écrites sur le disque, j’avoue ne pas avoir cherché à optimiser Redis pour l’écriture, j’ai gardé la configuration par défaut.

En revanche, Redis est bien meilleur en lecture, malgré le surplus de traitements dû à la désérialisation Jackson. Et c’est ce qu’on cherche dans notre cas d’usage, nos listes de liens vont être lus beaucoup plus souvent que modifiées. Et pour ceux qui se poseraient la question, oui j’ai bien créé les indexes dans Mongo.

Ce qu’il faut retenir, c’est que dans bien des cas, une base de données document ou SQL n’est pas forcément obligatoire et qu’il vaut mieux démarrer simple et (très) efficace, quitte à changer par la suite…

Un peu de lecture si vous souhaitez en savoir plus sur Redis : Redis: the Definitive Guide: Data Modeling, Caching, and Messaging

@Configuration

public class RequestConfiguration {

@Value(value = "${repository?InMemoryRepository}")

private String repository;

}

Pour ce faire, il faut configurer le property placeholder de Spring pour :

- Ignorer les @Value vide

- remplacer le séparateur par défaut (« : ») par « ? » qui est plus parlant.

<bean id="placeholderConfig">

<property name="locations">

<list>

<value>classpath:conf.properties</value>

</list>

</property>

<property name="ignoreResourceNotFound" value="true"/>

<property name="ignoreUnresolvablePlaceholders" value="true" />

<property name="valueSeparator" value="?" />

</bean>

Et voilà !

Maintenant il faut faire attention car Spring va ignorer toutes les properties null ce qui pourra provoquer des NullPointerException à l’exécution plutôt que des erreurs de configuration au démarrage de l’application…

]]>Avec Jersey, l’implémentation de référence de JAX-RS (JSR311) pas de prise de tête, tout est générés automatiquement.

Il suffit de faire deux choses :

- Créer une classe de type « com.sun.jersey.api.wadl.config.WadlGeneratorConfig »

- Passer cette classe en paramètre d’initialisation de votre servlet

public class SchemaGenConfig extends WadlGeneratorConfig {

@Override

public List configure() {

return generator( WadlGeneratorJAXBGrammarGenerator.class).descriptions();

}

}

<servlet>

<servlet-name>

banner

</servlet-name>

<servlet-class>

com.lateralthoughts.commons.web.LateralCommonsServlet

</servlet-class>

<init-param>

<param-name>

com.sun.jersey.config.property.WadlGeneratorConfig

</param-name>

<param-value>

com.lateralthoughts.commons.web.wadl.SchemaGenConfig

</param-value>

</init-param>

<load-on-startup>1</load-on-startup>

</servlet>

Le WADL est maintenant généré et accessible à cette adresse : http://localhost:port/maservlet/application.wadl

Pour aller plus loin, le wiki d’Oracle : https://wikis.oracle.com/display/Jersey/WADL

Merci à Aurélien Thieriot pour l’astuce

Devoxx France en deux mots : C’est la plus grande et la plus intéressante des conférences pour les développeurs Java en France.

Pour moi, ce fut une expérience formidable. En plus d’avoir appris quelques trucs, ce qui m’a fait le plus plaisir c’est d’avoir été conforté sur pas mal de choix que j’ai pu faire ou que je comptais appliquer prochainement. Hormis l’absence de desserts sucrés et le nombre limité de boissons, l’organisation fut parfaite. Un grand bravo aux organisateurs !

J’ai choisi d’illustrer ces trois jours de conférences par une série d’articles qui racontent ce que pourrait être une success story pour un développeur Java ayant eu une « idée » :

Pour la petite histoire, je craignais au début que limiter à 25% le nombre de speakers anglophones allait mathématiquement faire baisser le niveau des speakers. Cela c’est avéré faux, le niveau des Français fut excellent, même meilleurs que les anglophones que j’ai pu voir. Bravo à tous et vive la France !

Quant à moi (beaucoup m’ont posé la question), si je n’ai rien présenté et que je n’ai pas non plus voulu participer à la préparation de cette première de Devoxx France bien que je sois un Geek Passionné avec plein de choses à raconter, c’est que j’ai déjà beaucoup de projets en cours et je pense qu’il est important de garder un certain équilibre entre vie professionnelle, loisirs, famille et amis afin de ne pas finir en « burnout » (En passant j’ai bien rigolé en lisant http://501manifesto.org/ ).

Je remercie ma société de m’avoir payé la conférence ainsi que l’hôtel au Marriott (4 étoiles c’est la classe !). Et si vous n’êtes pas encore Freelance ou que vous ne faites pas partie d’une société qui vous laisse gérer votre budget tel que Lateral Thoughts, il est peut être temps d’y réfléchir…

A l’année prochaine à Devoxx !

]]>

Web Oriented Architecture

Avant d’être Startupeur, Gérard était architecte urbaniste respecté et vénéré. Mais trop souvent, il a essayé de plier le web pour faire des applications dites « Stateful » où l’état du client est conservé côté serveur via les sessions. Ce qui amène pas mal de problèmes, en terme de performance bien sûr, car il est du coup difficile d’avoir un cache efficace, mais aussi des problèmes de développement, qui n’a jamais galéré à gérer le bouton « back » et à devoir mettre un bouton « back » spécifique dans son application alors que le navigateur lui-même en possède déjà un ?

La présentation de Habib, qui s’approche de la keynote a hypnotisé le public (et Gérard) en cassant les architectures dites « stateful » et antiweb, celle de Sadek et Guillaume montre que Play! pousse le développeur à embrasser le Web plutôt qu’à lutter contre lui.

Mais au fait c’est quoi une architecture Web ?

- Ressource based : Utilisation des URI et des mediatypes pour identifier et exprimer les « ressources » fournies par l’application

- Stateless : L’état de la conversation est gérée côté client, dans le browser. Le client change l’état de l’application via des commandes au serveur (verbes http PUT, POST et DELETE)

- HTTP powered : Utilisation du protocole HTTP et de ses verbes à bon escient : PUT, POST, DELETE, GET. Une application qui embrasse le web est une application qui ne fait que du CRUD.

WAT ? Mais comment va faire Gérard pour ne faire que du CRUD ? Son application fait des vrais trucs de barbus.

En fait c’est super simple, lorsque vous avez de faire un truc « compliqué » (qui n’est pas CRUD), comme par exemple, déplacer une somme d’argent d’un compte A (ressource) à un compte B (autre ressource) vous n’allez, côté client ni demander de modifier le compte A, ni demander de modifier le compte B, mais ajouter une ressource à votre système (via un PUT) et ça, ben c’est du CRUD. Cette commande déclenchera l’exécution de notre traitement métier « complexe » de manière « Atomic » et « Asynchrone » (Toi qui es perspicace tu auras reconnu l’objet bancaire Transaction )

Ceci permet d’avoir entre autre une interface réactive, car l’envoie d’une commande dans une queue est d’une complexité constante.

Ha oui mais du coup, quand on va requêter pour savoir combien il y a sur le compte B il va falloir parcourir toutes les transactions ! (Gérard est fier de sa perspicacité)

Biensûr que non !! La solution est dans le chapitre en dessous avec CQRS, on va séparer le modèle métier d’écriture et le modèle métier de lecture et pré-calculer, dé-normaliser pour être efficace autant en écriture qu’en lecture.

Pour aller plus loin : Implementing REST

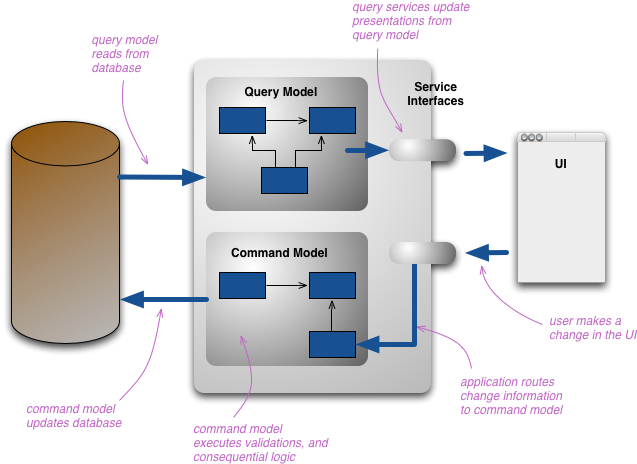

CQRS

Le lien fort entre CQRS et la WOA, c’est le CRUD, une architecture CQRS est une architecture à base de commande, comme en WOA, l’idée est de créer des commandes plutôt que de modifier plusieurs entités du modèle. Cela revient donc à faire du CRUD, comme en WOA.

Une architecture CQRS (Command Query Responsabilty Segragation) sépare le modèle d’écriture du modèle de lecture ce qui va permettre :

- De ne pas fetcher d’informations inutiles (On n’a pas besoin du nom du client B pour calculer le solde du client A …) Qui n’a jamais du fetcher des informations inutiles parce que le modèle est unique pour toute l’application ?

- De pré-calculer de manière asynchrone toutes les opérations fortement demandées pour s’approcher d’une complexité constante ( ou linéaire, mais sur un nombre réduit d’éléments).

Bien, se dit Gérard, mais si je suis asynchrone, je ne vais pas voir tout de suite le résultat de ma transaction sur mon compte ! C’est vrai. Mais ce n’est pas grave il faut être « relax », Habid appelle ça la « relaxation temporelle ».

Pour aller plus loin :

Le mot de la fin

Maintenant qu’on ne fait que du CRUD, du Stateless et de l’asynchrone, cela permet de découper facilement nos applications en plusieurs petites applications ou API qui ne traitent que d’une seule problématique, réduisant encore la complexité du système d’information. Les applications web « finales » agrègent ensuite ces API pour présenter quelque chose de « complet » à l’utilisateur final. Évidement ces APIs simples et « unitaires » sont réutilisables par autant d’applicatifs finaux que nécessaires, permettant ainsi une ré-utilisatibilité et une interopérabilité maximale.

Appelez ça comme vous voulez, WOA, REST, CQRS, HTTP, Web. L’avenir est dans la simplicité du CRUD, l’asynchrone et le Stateless. C’est aussi l’avis de Gérard. Est-ce le vôtre ?

]]>

Yeah ! Maintenant que Gérard a son business plan qui roule, qu’il a mis en ligne un premier prototype et que les premiers clients commencent à taper au portillon, il est temps de passer à la vitesse supérieure : Créer sa société.

A Devoxx un quickie à particulièrement attiré mon attention : Celui de Andrew Spencer sur son idée de faire une SSII Coopérative. Ce qui est marrant c’est que c’est ce que nous avons fait depuis quelques mois en créant Lateral-Thoughts.

Pourquoi une SSII coopérative ?

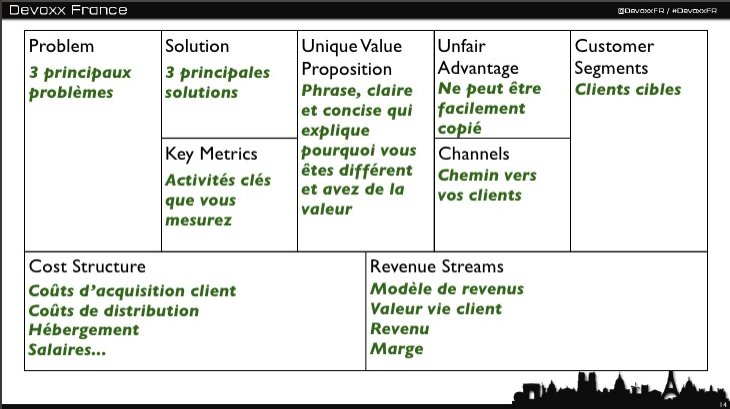

Appliquons le « Lean Canvas » et répondons à quelques questions :

- Problem: En SSII il n’y a pas d’argent, pas de fun et pas de liberté, l’innovation n’est pas encouragée.

- Solution: Faisons une SSII qui donne de l’argent (tous actionnaires) du timeoff pour le fun et l’innovation et de la liberté d’action (management plat).

- Key metrics : Salaires moyen (Argent), Satisfaction des membres (Fun et Liberté)

- Uniq Value Proposition : Une bande de développeurs passionnés et auto-organisés qui s’éclatent à faire en codant et en apprenant ensemble.

- Unfair advantage: On s’en fout, copiez nous, ça nous fera plaisir. D’un point de vue business : Nos réseaux, notre toile « unique »

- Channels: Les réseaux de nos membres, leur rayonnance. Ce blog et d’autres ^^

- Customer segments: Les PME, grands comptes et startups.

- Cost Structure: Quasiment rien, un comptable à 1000€ / an. Pas de locaux. Pas de commerciaux. Pas de managers. Pas de boss.

- Revenue Streams: Prestations, Formations, Editions de solutions logicielles.

Il s’agit du canvas pour Lateral Thoughts mais vous pouvez tout à fait imaginer votre propre SSII coopérative pour répondre à une autre problématique. L’exemple du réseau libre-entreprise en est un autre.

Et pour ma startup ?

Les startupeurs sont des gens innovants. Le problème c’est qu’une fois que le produit est devenu « Legacy » où passe l’innovation ? Généralement on revend la structure et on part créer autre chose. Sauf qu’il n’est pas aisé de réussir à chaque fois, surtout lorsqu’on a qu’un seul cerveau. Pourquoi ne pas mettre en place dès le départ dans sa société une organisation qui permettra à l’innovation d’émerger et ce, de manière durable ? Certains l’ont très bien réussi, je pense à W.L. Gore, Whole Foods ou Google. Il suffit de copier, tous leurs secret sont expliqués dans ce livre : The Future of Management

La clé du management du futur et de passer par des sociétés coopératives, le modèle le plus connu est celui de la sociocratie que je résume en quelques points ici :

- Une personne = une voix

- Transparence totale (même et surtout du compte bancaire)

- Décision prise par consensus (tout le monde, à défaut d’être d’accord doit consentir pour qu’une décision soit prise)

Ce type de société à un coût, car une décision prise par consensus prend du temps alors qu’en société standard, le patron prend les décisions le matin seul dans sa douche. Mais le jeu en vaut la chandelle. Les membre d’une telle société donnent le meilleur d’eux-mêmes, ils se sentent investis, ils se sentent d’une même famille avec un but commun, mais aussi des objectifs individuels (qui ne vont pas contre les objectifs collectifs). La transparence fait que chacun a conscience de l’objectif de l’entreprise, de son business. Et chacun en est responsable.

Alors maintenant, qu’allez-vous faire ? Allez-vous continuez à subir ou allez-vous prendre votre vie en main (en intégrant une société coopérative) ?

]]>En bon petit développeur Java, Gérard garde sa petite idée pour lui, développe la nuit et pendant ses congés pour finalement sortir de l’ombre et mettre en ligne THE application (pour l’instant hébergée directement sur son ordinateur personnel)

Et là, vous connaissez la suite, ça fait psssiiichhhhhttt. L’idée n’est pas trop mal mais :

- Elle n’atteint pas exactement la cible

- Il n’existe aucun vecteur pour que le client soit informé du produit

- Gérard n’a pas prévu de façon de gagner de l’argent

- Finalement, l’heure de gloire arrive enfin, un groupe de chinois tombe sur son site et le copie en deux jours… (c’était bien la peine de l’avoir gardé secrète ton idée Gérard ! )

Ce que nous apprend Camille Roux lors de son talk à Devoxx (et sur slideshare) c’est qu’une idée n’a pas de valeur, tout le monde à des idées. Ce qui a de la valeur c’est sa réalisation. Il nous raconte que lors d’un startup week-end, il s’est retrouvé avec six profils « business ». Six business-men qui ne savent pas coder, mais comment allait il pouvoir les occuper ?

Et là surprise, il existe un autre monde, un monde qui n’est pas le monde du développement et qui a aussi des méthodes et des outils qui ont fait leurs preuves.

Lean Canvas

Camille nous présente l’un de ces outils : le « Lean Canvas » et conseil que tous les voyants soient au vert avant de commencer le développement du produit.

- Problem : Quels problèmes résolvez vous ? Moins vous en résolvez, mieux c’est.

- Solution : Quelles solutions apportez vous ? Moins vous en apportez, mieux c’est.

- Key Metrics : Quels seront les indicateurs qui vont vous permettre de valider le succès de votre idée ? (Ex : le nombre de visites, d’utilisateurs ou de produits vendus)

- Unique Value Proposition : Qu’est-ce que vous apportez que les concurrents n’apportent pas ?

- Unfair advantage : Pourquoi on ne pourra pas vous copier facilement (Ex : une image de marque)

- Customer segments : Votre cible (Ex : La gamine de 13 ans avec un forfait bloqué à dépenser)

- Channels : Comment allez-vous atteindre votre cible ? (Ex : j’ai déjà un site qui fait 10 000 visites de ma cible par jour)

Pour remplir le tableau n’hésitez pas à parler de votre idée à vos amis, votre famille, au barman du coin ou évidemment à des représentant de votre cible. Une fois que tous les indicateurs sont au vert, vous vous rendrez compte que votre idée initiale n’est pas tout à fait la même qu’au départ, elle est largement meilleure.

Ce qui est marrant c’est que je me suis exercé à cette technique sur plusieurs types de projets et à chaque fois cela m’a apporté quelque chose. Même sur un projet open-source, même sur un projet d’entreprise de type « service ».

Pour aller plus loin :

- Running Lean: Iterate from Plan A to a Plan That Works

- Business Model Generation: A Handbook for Visionaries, Game Changers, and Challengers

Tester son idée

Maintenant que l’idée de Gérard a été retravaillée, il est temps de commencer à coder ! Enfin presque, pour tester une idée, un prototype c’est bien, mais il existe d’autres façons :

- Le questionnaire: Faites en un ! Pour savoir notamment si quelqu’un serait prêt à payer pour telle ou telle fonctionnalité. Ainsi vous pourrez démarrer avec la fonctionnalité qui a le plus de valeur et peut-être même avec déjà des clients !

- Sortez ! C’est en sortant, en allant voir vos futurs utilisateurs que vous aurez de nouvelles idées d’améliorations de votre produit, en voyant comment ils travaillent et quels sont leurs problèmes.

- Un article de blog: Si je blogue sur mon idée et que ça buzze, c’est que je suis certainement sur la bonne voie. C’est aussi une façon d’obtenir du feedback.

- Le prototype : Enfin ! Nous allons coder. Mais là encore il s’agit de tester une idée, n’allons donc pas perdre de temps à faire une architecture scalable du feu de dieu, le truc c’est de développer vite mais aussi de développer quelque chose d’agréable à voir. N’hésitez pas à recruter votre pote designer à cette étape là, sinon vous pouvez utiliser Twitter bootstap ou acheter un CSS sur themeforest (c’est ce que j’ai fait pour buildwall.com ). Camille est un développeur Ruby, il nous explique que pour développer une page de type CRUD, il ne faut pas y passer plus de 15min… En Java on ira jeter un oeil à Spring Roo ou Play! framework

Et maintenant, qu’allez-vous faire de vos idées (et de votre vie) ?

]]>

Le pour

– Je suis auteur de mon code, je l’assume et je l’écris de manière professionnelle en pensant à ceux qui vont me lire. C’est une idée que partage Robert C. Martin.

The @author field of a Javadoc tells us who we are. We are authors. And one thing about authors is that they have readers. Indeed, authors are responsible for communicating well with their readers. The next time you write a line of code, remember you are an author, writing for readers who will judge your effort.

– Surtout dans l’open-source, cela permet de laisser une trace de son investissement. Voir de se faire un nom.

– Il peut contenir l’adresse d’une mailing-list, ce qui permet, lors d’une question sur une classe de contacter directement les personnes responsables.

Le contre

– DRY : don’t repeat yourself : l’information est déja présente dans le SCM (git, svn ..).

– Le code appartient à tous : le @author doit donc etre collectif.

– Si il ne contient que l’auteur initial, celui-ci ne vaut pas plus que les autres.

– évite la sacralisation d’un unique développeur

– Pose le problème de savoir quand on doit se rajouter dans la balise @author.

Je laisse à Emmanuel Bernard le tweet de la fin :

Merci à Sébastien PRUNIER @sebprunier, Pierre TEMPLIER @ptemplier, Emmanuel LECHARNY, François Sarradin @fsarradin, Guillaume LOURS @guillaumelours, Jean-Laurent Morlhon @morlhon, Arnaud Héritier @aheritier , Sébastien Deleuze @sdeleuze , Yannick AMEUR @yannickameur , Robin Komiwes @robinkomiwes , Jollivet Christophe @jollivetc , Jérémy Sevellec @jsevellec, Julien Jakubowski @jak78 , Nicolas De loof @ndeloof, Nicolas François @nicofrancois , Francois Marot @FrancoisMarot , Jean Helou @jeanhelou, Benoît Dissert @bdissert , Olivier Jaquemet @OlivierJaquemet , Aline Paponaud @bootis , Benoît Dissert @bdissert , Nicolas Delsaux @riduidel et aux autres …

]]>

Pour me préparer aux sélections de code story et pouvoir coder pendant 2 jours une application devant des centaines de développeurs à Devoxx, je me suis entrainé à refactorer une méthode en m’enregistrant.

Le bénéfice que j’attendais de l’exercice était de :

- M’entendre parler pour détecter mes défauts d’expressions et les corriger, car le jour J il faudra expliquer ce qu’on fait et pourquoi, le tout en codant ! Pas facile…

- Maîtriser au maximum mon IDE pour être rapide à coder, rien de plus ennuyeux que de regarder un développeur coder trop lentement !

Pour la petite histoire, je suis partie d’une classe que je venais de refactorer chez un client, il s’agit donc d’un exemple réel. J’ai fait environ 15 essais avant les sélections pour finalement me faire éliminer ! Je suis bon perdant, et je me suis dit que les quelques techniques simples que j’explique pouvaient être intéressantes et que c’était dommage de garder le screencast pour moi. Du coup j’ai refait 5 essais et voici le résultat :

Ce n’est pas parfait ! J’ai même fait une grossière erreur en cassant le comportement de la méthode. Le premier qui trouve où gagne une bière (la date du commentaire faisant foi) ! Si vous trouvez d’autres boulettes ça marche aussi, à l’exclusion de l’utilisation de framework ou de l’API java, Boolean.compareTo par exemple, car ce n’est pas le propos de l’exercice. D’ailleurs s’il y a une chose que je retiens c’est qu’on peut toujours faire mieux !

Pour ceux qui voudrait faire pareil :

- Achetez un bon casque / micro ! (le mien clic! de temps en temps, il faut que j’en rachète un !)

- Sous linux j’utilise Kazam pour l’enregistrement et key-mon pour montrer ce que j’écris.

- Limitez vous à un exercice de moins de 10minutes, on décroche si c’est trop long.

- N’ayez pas honte !

Bon code à tous !

]]> . Cet article ne reprends qu’une partie du talk: les points que j’ai pu rencontrer en entreprise.

. Cet article ne reprends qu’une partie du talk: les points que j’ai pu rencontrer en entreprise.

1. L’hydre

Hydra est une entité qui a la particularité de contenir une liste immuable de tête (heads.)

@Entity

public class Hydra {

private Long id;

private List heads = new ArrayList();

@Id @GeneratedValue

public Long getId() {...}

protected void setId() {...}

@OneToMany(cascade=CascadeType.ALL)

public List getHeads() {

return Collections.unmodifiableList(heads);

}

protected void setHeads(List heads) {...}

}

// creates and persists the hydra with 3 heads

// new EntityManager and new transaction

Hydra found = em.find(Hydra.class, hydra.getId());

La question est la suivante, combien d’appel sont fait en base de données lors de la deuxième transaction (créer lors de em.find).

(a) 1 select

(b) 2 selects

(c) 1+3 selects

(d) 2 selects, 1 delete, 3

inserts

(e) None of the above

Pendant la recherche, em.find entraine un unique select en base de donnée sur l’hydre.

Pendant le commit qui est effectué à la fin de la transaction, hibernate vérifie que la collection n’est pas dirty, c’est à dire que les objets devraient être recréés en comparant les références objects des listes. Un deuxième select est alors effectué sur les têtes. Dans notre cas, les références ne correspondant pas, l’ensemble de la liste est alors recréé, ce qui explique le delete et les 3 inserts.

Contrairement à ce que l’on pourrait penser dans un premier temps, la bonne réponse est donc la réponse d.

Il faut donc être bien conscient que si on a un objet qui contient une collection et qui porte la liaison, si on affecte une nouvelle liste à l’élément, la collection est recrée entièrement : un delete et n insertions d’éléments. On peut rencontrer également ce genre de problème si on utilise des outils qui suppriment les proxies hibernate sur les objets.

En régle générale, il vaut mieux travailler directement avec les collections retournées par hibernate à moins de savoir ce que l’on fait.

@Entity

public class Developer {

@Id @GeneratedValue

private Long id;

private String mainTechnology;

public boolean likesMainTechnology() {

return "hibernate".equalsIgnoreCase(mainTechnology);

}

}

// creates and persists a developer that uses hibernate as mainTechnology

// new EntityManager and new transaction

Developer dev = em.find(Developer.class, id);

boolean foundCoolStuff = false;

for (String tech : new String[]{"HTML5", "Android", "Scala"}) {

dev.setMainTechnology(tech);

// othersAreUsingIt entraine select count(*) from Developer where mainTechnology = ? and id != ?

if (othersAreUsingIt(tech, dev) && dev.likesMainTechnology()) {

foundCoolStuff = true; break;

}

}

if (!foundCoolStuff) {

// still use hibernate

dev.setMainTechnology("hibernate");

}

(a) 2 selects

(b) 4 selects

(c) 4 selects, 1 update

(d) 4 selects, 4 inserts

(e) None of the above

La bonne réponse est la réponse d, 4 selects et 4 inserts. En effet, hibernate doit garantir la bonne valeur des requêtes exécutées et parfois doit effectuer une flush pendant une transaction. Si on n’effectue plus l’appel à othersAreUsingIt (qui entraine un select sur la table Developer), il n’y a plus d’update.

List semantics

@Entity

public class Forest {

@Id @GeneratedValue

private Long id;

@OneToMany

Collection<Tree> trees = new HashSet<Tree>();

public void plantTree(Tree tree) {

trees.add(tree);

}

}

// creates and persists a forest with 10.000 trees